Oracle RAC構築のためのOracle Grid Infrastructure 11g R2インストール

目次

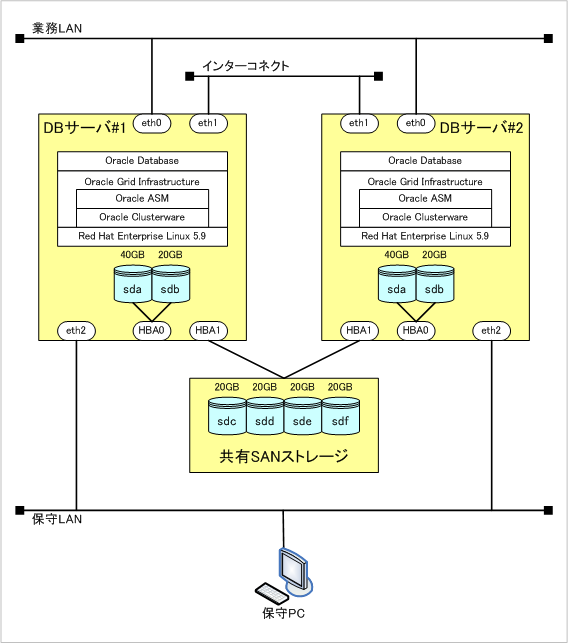

構成

想定環境

Oracle Database 11g R2をインストールするサーバ構成を以下の通りとしました。 開発環境などを想定した最低限の構成としています。

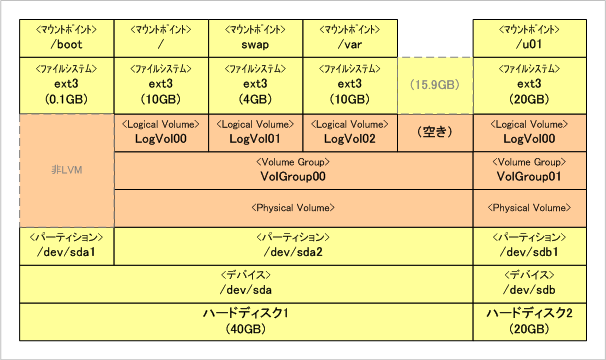

Linux、Oracle製品をインストールするディスクの構成は以下の通りです。

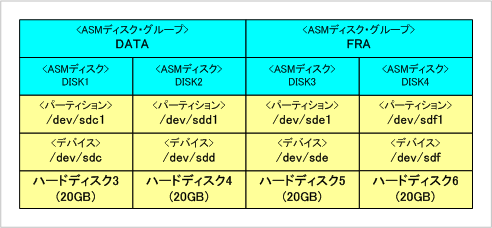

データベースを格納するディスクの構成は以下の通りです。

サーバ構成

OSバージョン

Red Hat Enterprise Linux 5.9 64bit

ソフトウェア一覧

Oracle Database 11g Release 2 (11.2.0.3.0) for Linux x86-64

Oracle Database 11g Release 2 Grid Infrastructure (11.2.0.3.0) for Linux x86-64

環境構築

設定

ASMディスクの作成

ASMのディスク・グループとして構成させるためのディスクを準備します。 まずはASMを利用するための初期化処理を行います。 その後実際にディスクをASMディスクとして初期化します。 ASM用のディスクは共有ディスク上に存在しているため、 ディスクの初期化はDBサーバ#1からのみ実行します。

※DBサーバ#1で実行する※ # oracleasm configure -i Configuring the Oracle ASM library driver. This will configure the on-boot properties of the Oracle ASM library driver. The following questions will determine whether the driver is loaded on boot and what permissions it will have. The current values will be shown in brackets ('[]'). Hittingwithout typing an answer will keep that current value. Ctrl-C will abort. Default user to own the driver interface []: grid Default group to own the driver interface []: asmadmin Start Oracle ASM library driver on boot (y/n) [n]: y Scan for Oracle ASM disks on boot (y/n) [y]: y Writing Oracle ASM library driver configuration: done You have new mail in /var/spool/mail/root # oracleasm init Creating /dev/oracleasm mount point: /dev/oracleasm Loading module "oracleasm": oracleasm Mounting ASMlib driver filesystem: /dev/oracleasm # fdisk /dev/sdc # fdisk /dev/sdd # oracleasm createdisk DISK1 /dev/sdc1 Writing disk header: done Instantiating disk: done # oracleasm createdisk DISK2 /dev/sdd1 Writing disk header: done Instantiating disk: done # oracleasm listdisks DISK1 DISK2

DBサーバ#2でも同様にASMを利用するための初期化処理を行います。 ただし、ASMディスクとしての初期化は行わず、DBサーバ#1で初期化した ASMディスクをスキャンして認識させる処理を行います。

※DBサーバ#2で実行する※ # oracleasm configure -i Configuring the Oracle ASM library driver. This will configure the on-boot properties of the Oracle ASM library driver. The following questions will determine whether the driver is loaded on boot and what permissions it will have. The current values will be shown in brackets ('[]'). Hittingwithout typing an answer will keep that current value. Ctrl-C will abort. Default user to own the driver interface []: grid Default group to own the driver interface []: asmadmin Start Oracle ASM library driver on boot (y/n) [n]: y Scan for Oracle ASM disks on boot (y/n) [y]: y Writing Oracle ASM library driver configuration: done # oracleasm init Creating /dev/oracleasm mount point: /dev/oracleasm Loading module "oracleasm": oracleasm Mounting ASMlib driver filesystem: /dev/oracleasm # oracleasm scandisks Reloading disk partitions: done Cleaning any stale ASM disks... Scanning system for ASM disks... Instantiating disk "DISK1" Instantiating disk "DISK2"

LinuxでGUI環境(X Window System)を起動します。 X Window SystemはTeraTermからは起動できないので、Linuxのコンソールなどで実行してください。 なお、ランレベル5でLinuxを起動している場合はこの手順は不要です。

# startx

ターミナル上で以下のコマンドを実行します。

# mount /dev/cdrom /media/cdrom mount: ブロックデバイス /dev/cdrom は書き込み禁止です。読込み専用でマウントします # xhost + access control disabled. clients can connect from any host # su - orace $ xhost + access control disabled. clients can connect from any host $ /media/cdrom/grid/runInstaller

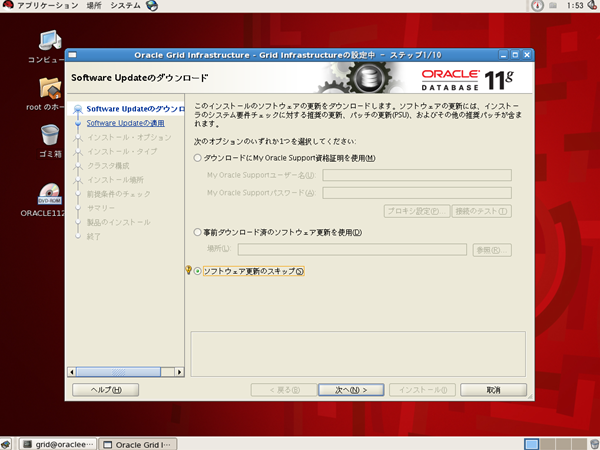

Software Updateのダウンロード

[ソフトウェア更新のスキップ]をチェックして、[次へ]ボタンをクリックします。

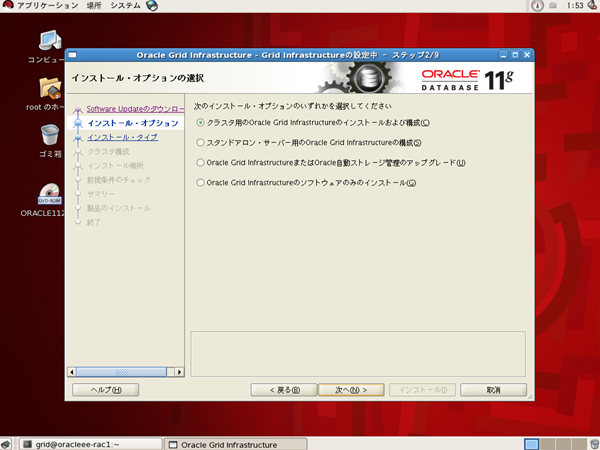

インストール・オプションの選択

[クラスタ用のOracle Grid Infrastructureのインストールおよび構成]が選択されていることを確認して[次へ]ボタンをクリックします。

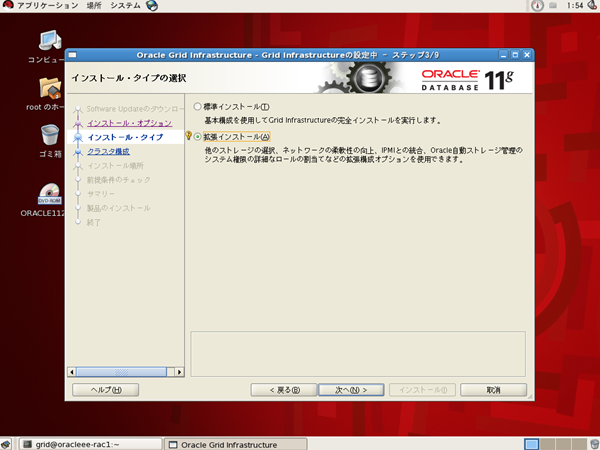

インストール・タイプ

[拡張インストール]を選択して、[次へ]ボタンをクリックします。

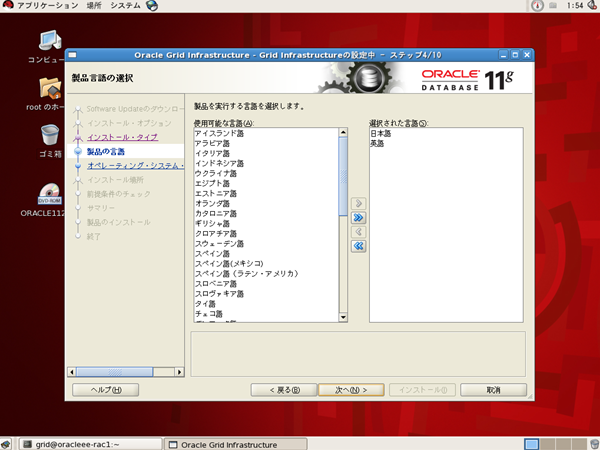

製品の言語

選択された言語の欄に[日本語]と[英語]が表示されていることを確認して、[次へ]ボタンをクリックします。

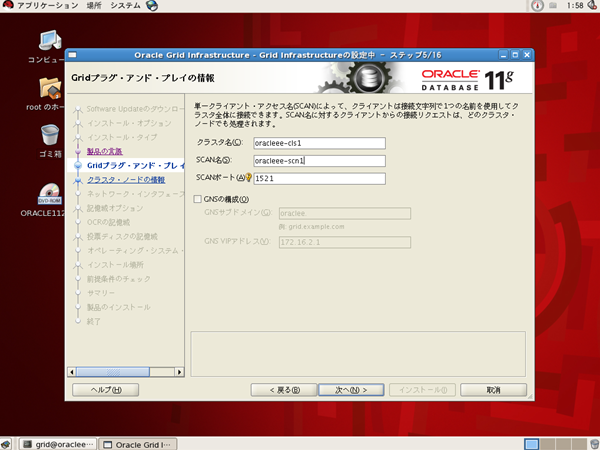

Gridプラグ・アンド・プレイの情報

[GNSの構成]チェックボックスのチェックを外して、[クラスタ名]、[SCAN名]、[SCANポート]を以下の通り入力し、[次へ]ボタンをクリックします。

| クラスタ名 | rac-cls1 |

|---|---|

| SCAN名 | rac-scan1 |

| SCANポート | 1521 |

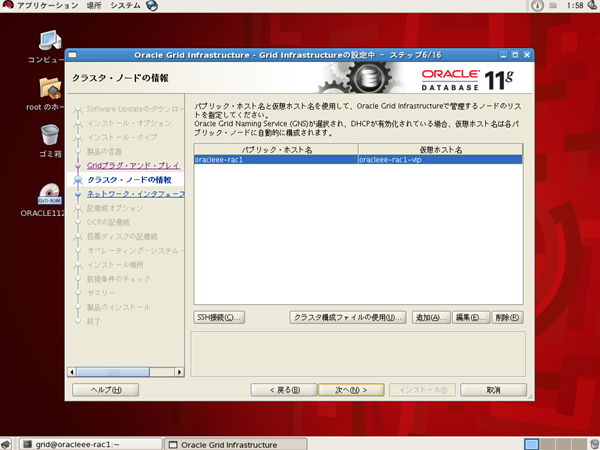

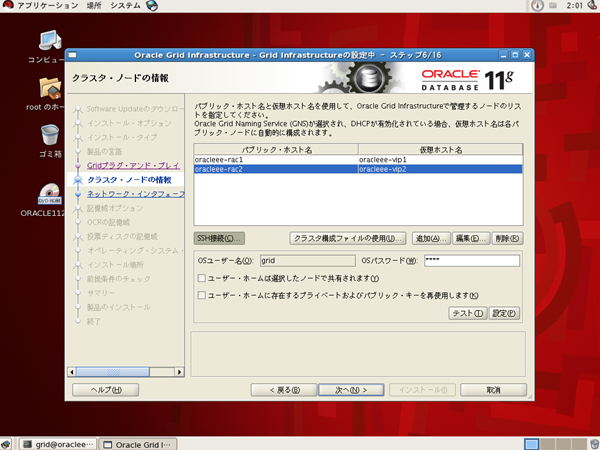

クラスタ・ノードの情報

[編集]ボタンをクリックします。

[パブリック・ホスト名]と[仮想ホスト名]を以下の通り入力し、[OK]ボタンをクリックします。

| パブリック・ホスト名 | rac-node1 |

|---|---|

| 仮想ホスト名 | rac-vip1 |

【No image】

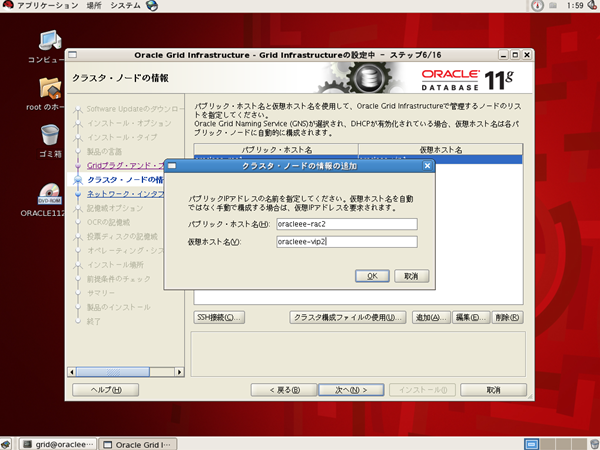

[追加]ボタンをクリックします。

【No image】

「クラスタ・ノードの情報の追加」画面が表示されたら[パブリック・ホスト]と[仮想ホスト名]を以下の通り入力し、[OK]ボタンをクリックします。

| パブリック・ホスト名 | rac-node2 |

|---|---|

| 仮想ホスト名 | rac-vip2 |

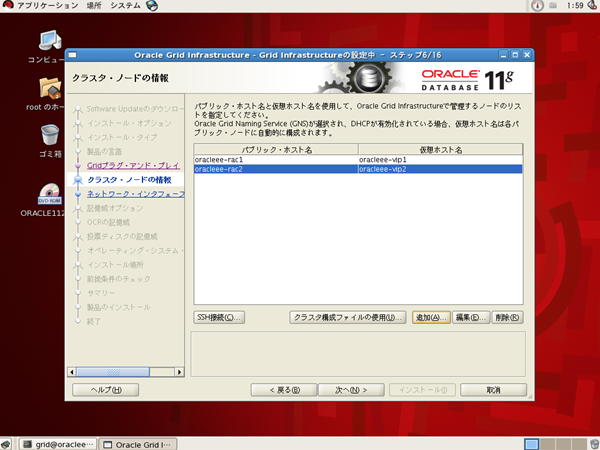

[SSH接続]ボタンをクリックします。

[OSパスワード]にgridユーザのパスワードを入力し、[設定]ボタンをクリックします。

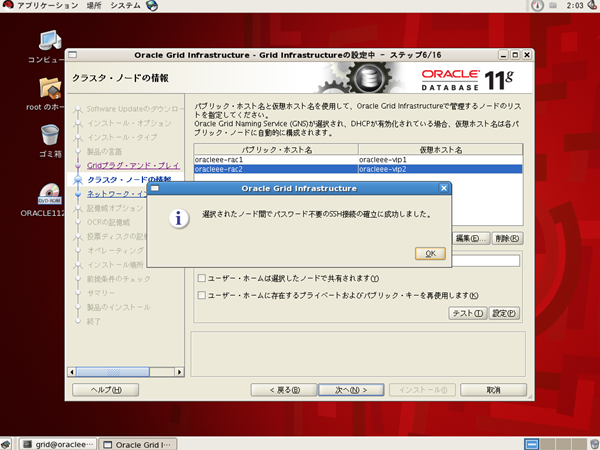

2台のクラスタ・ノード間でSSH接続に成功したことを確認できたら、[OK]ボタンをクリックします。

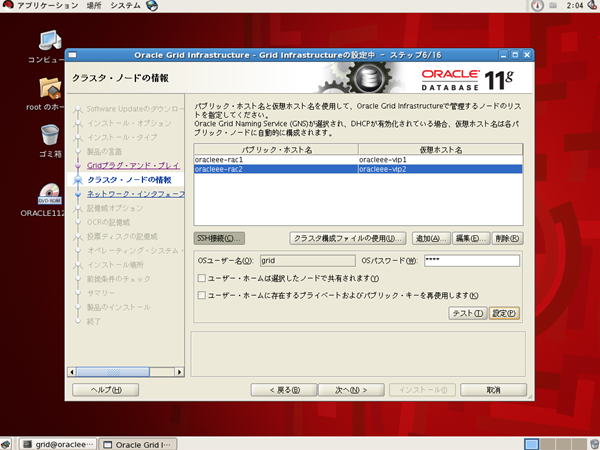

[次へ]ボタンをクリックします。

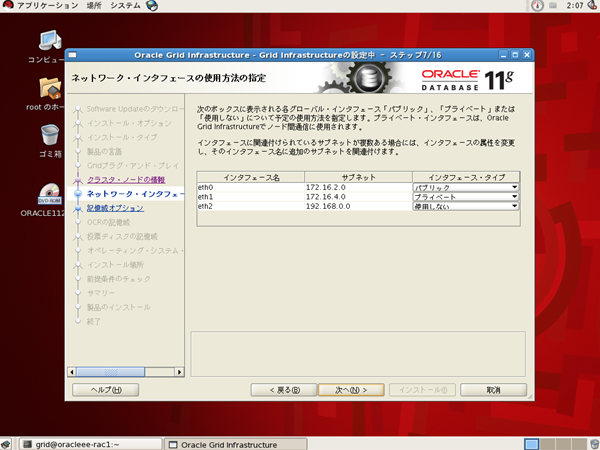

ネットワーク・インタフェースの使用方法の指定

[インタフェース名]、[サブネット]、[インタフェース・タイプ]が以下の通りとなっていることを確認し、[次へ]ボタンをクリックします。

| インタフェース名 | サブネット | インタフェース・タイプ |

|---|---|---|

| eth0 | 192.168.10.0 | パブリック |

| eth1 | 192.168.20.0 | プライベート |

| eth2 | 192.168.0.0 | 使用しない |

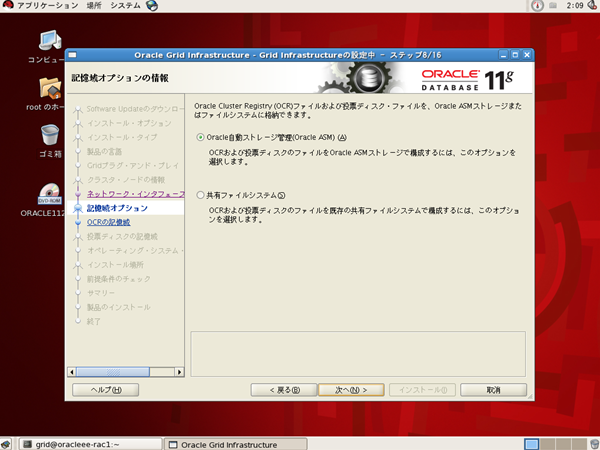

記憶域オプション

[Oracle自動ストレージ管理(Oracle ASM)]が選択されていることを確認し、[次へ]ボタンをクリックします。

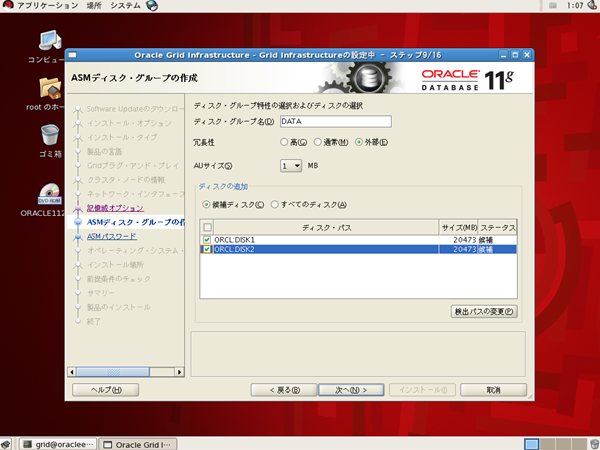

ASMディスク・グループの作成

ディスクグループ名は識別できる名前であれば何でも良いので、デフォルトのまま『DATA』としておきます。

今回は開発環境想定なので冗長性は最低限必要なレベルのみ確保するため、『外部』とします。通常ディスクをRAID構成とするなど、

Oracle以外の機能で冗長性を確保している場合にこれを選択します。

外部で冗長性を確保せずにこの値を選択した場合は、一つのディスクの故障でデータが消失してしまうので、

通常はRAIDなど外部で冗長性を確保するか、ディスクを3本以上準備して[冗長性]に『通常』を選択してください。

ディスクの追加ではASM用に準備したディスクが2つデフォルトで表示されているのでこれを選択し、[次へ]ボタンをクリックします。

| ディスク・グループ名 | DATA |

|---|---|

| 冗長性 | ○高 ○通常 ●外部 |

| AUサイズ | 1MB |

| ディスクの追加 | ■ORCL:DISK1 20473MB 候補 ■ORCL:DISK2 20473MB 候補 |

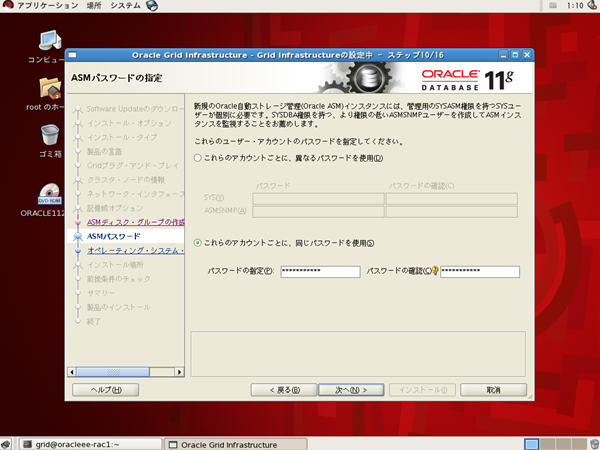

ASMパスワードの指定

SYSとASMSNMPユーザのパスワードは簡略化のため同じパスワードを設定します。 [これらのアカウントごとに、同じパスワードを使用]を選択して、[パスワードの指定]と[パスワードの確認]に 同じパスワードを入力し、[次へ]ボタンをクリックします。

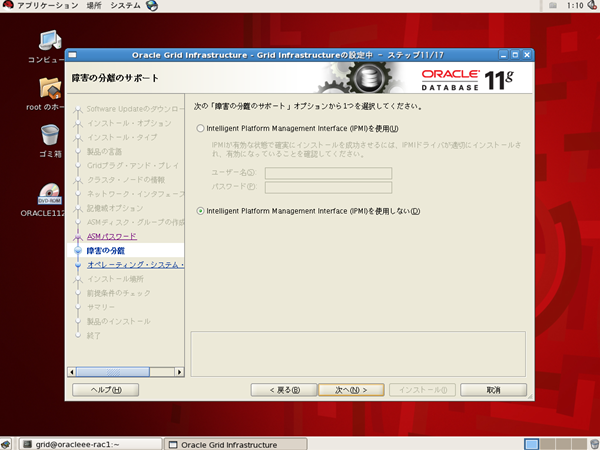

障害の分離のサポート

[Intelligent Platform Management Interface(IPMI)を使用しない]が選択されていることを確認し、[次へ]ボタンをクリックします。

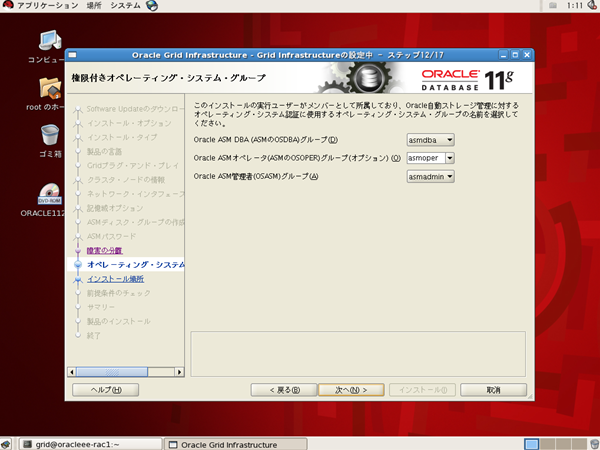

権限付きオペレーティング・システム・グループ

以下の通り選択されていることを確認し、[次へ]ボタンをクリックします。

| Oracle ASM DBA (ASMのOSDBA)グループ | asmdba |

|---|---|

| Oracle ASMオペレータ(ASMのOSOPER)グループ | asmoper |

| Oracle ASM管理者(OSASM)グループ | asmadmin |

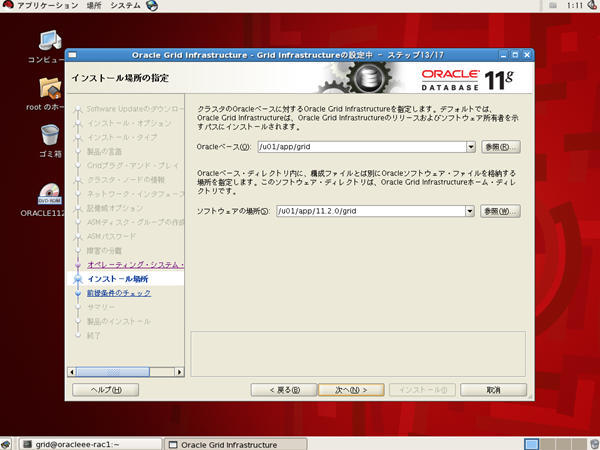

インストール場所の指定

以下の通り設定されていることを確認し、[次へ]ボタンをクリックします。

| Oracleベース | /u01/app/grid |

|---|---|

| ソフトウェアの場所 | /u01/app/11.2.0/grid |

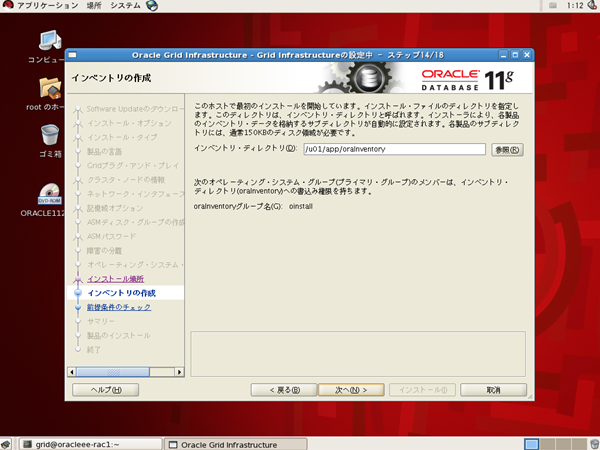

インベントリの作成

[インベントリ・ディレクトリ]が以下の通り設定されていることを確認し、[次へ]ボタンをクリックします。

| インベントリ・ディレクトリ | /u01/app/oraInventory |

|---|

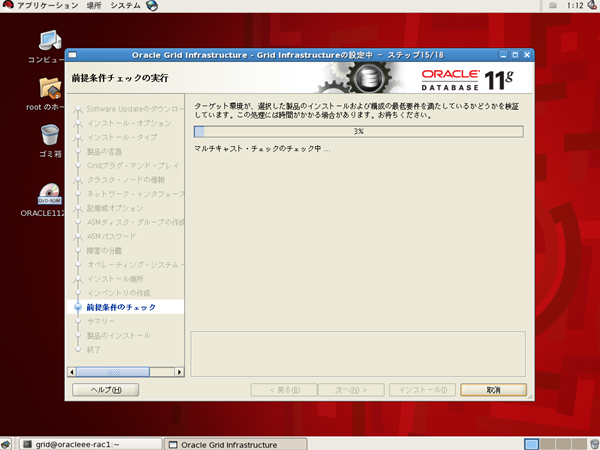

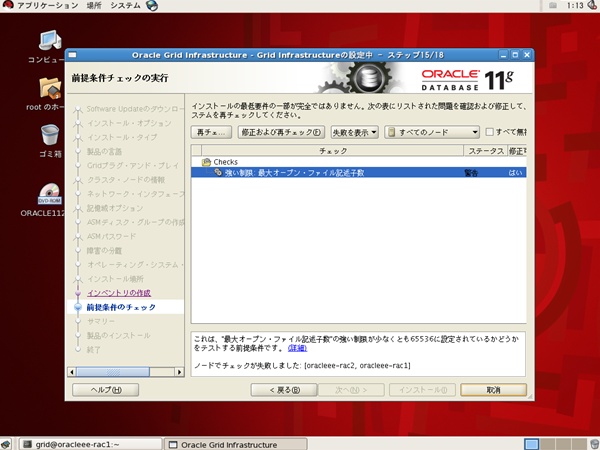

前提条件チェックの実行

Oracle Grid Infrastructureをインストールするために必要な前提条件を満たしているか自動でチェックされます。

チェックした結果、前提条件を満たしていない項目が表示されます。 前提条件を全て満たしている場合は、この画面は表示されません。

※前提条件を満たしていない場合にのみ表示

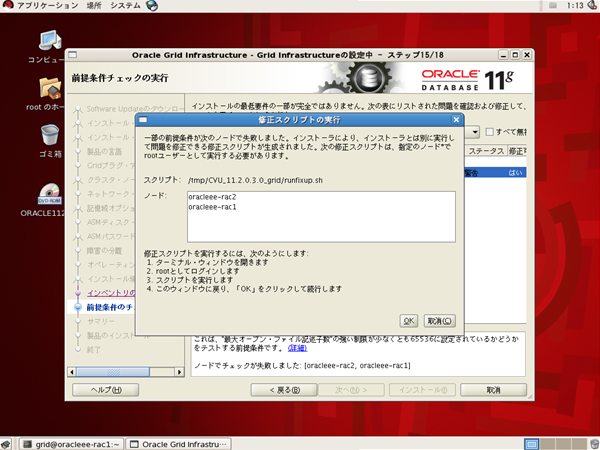

前提条件を満たしていない場合は、[修正および再チェック]をクリックします。 例としてカーネルパラメータが条件を満たしていない場合の画面を表示しています。 このような場合は、自動で修正スクリプトが生成され、 それを実行することで設定を変更し、前提条件をクリアすることができます。 画面に表示されている通りのノードでスクリプトを実行します。 この場合、Oracleのインストーラとは別にターミナルを起動し、そこでスクリプトを実行します。

※前提条件を満たしていない場合にのみ表示

前提条件を満たしていない場合で、かつスクリプトの実行指示が表示された場合にのみ実行してください。

※DBサーバ#1で実行する※

# /tmp/CVU_11.2.0.3.0_grid/runfixup.sh

Response file being used is :/tmp/CVU_11.2.0.3.0_grid/fixup.response

Enable file being used is :/tmp/CVU_11.2.0.3.0_grid/fixup.enable

Log file location: /tmp/CVU_11.2.0.3.0_grid/orarun.log

uid=501(grid) gid=501(oinstall) 所属グループ=501(oinstall),504(asmadmin),505(asmdba),506(asmoper)

※DBサーバ#2で実行する※

# /tmp/CVU_11.2.0.3.0_grid/runfixup.sh

Response file being used is :/tmp/CVU_11.2.0.3.0_grid/fixup.response

Enable file being used is :/tmp/CVU_11.2.0.3.0_grid/fixup.enable

Log file location: /tmp/CVU_11.2.0.3.0_grid/orarun.log

uid=501(grid) gid=501(oinstall) 所属グループ=501(oinstall),504(asmadmin),505(asmdba),506(asmoper)

「修正スクリプトの実行」画面で[OK]ボタンをクリックします。

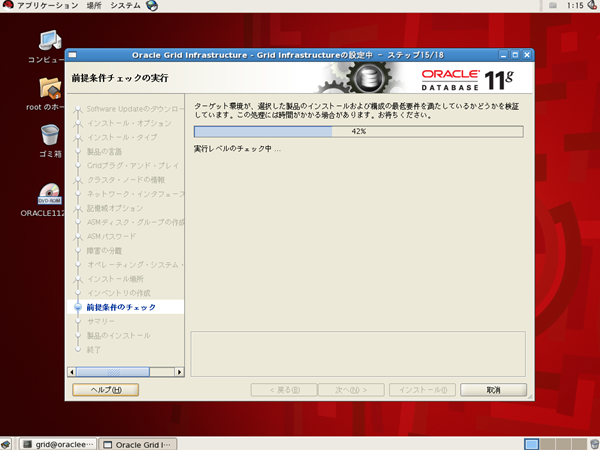

前提条件のチェックが再実行されます。

※前提条件を満たしていない場合にのみ表示

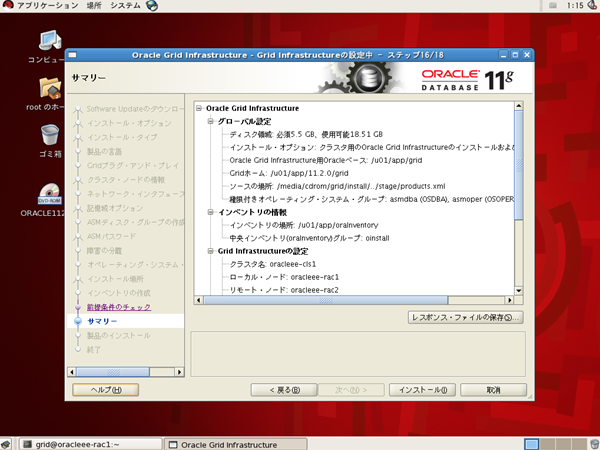

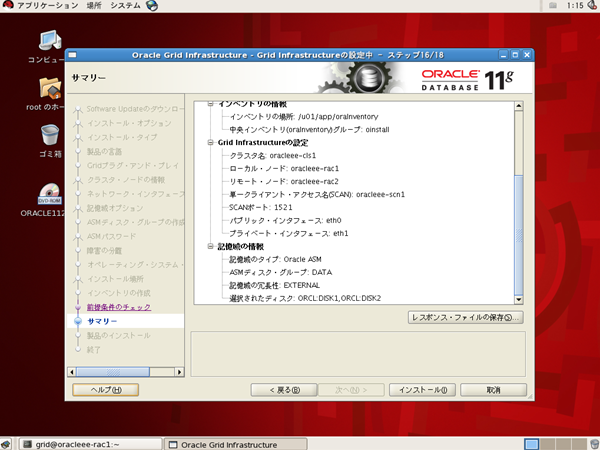

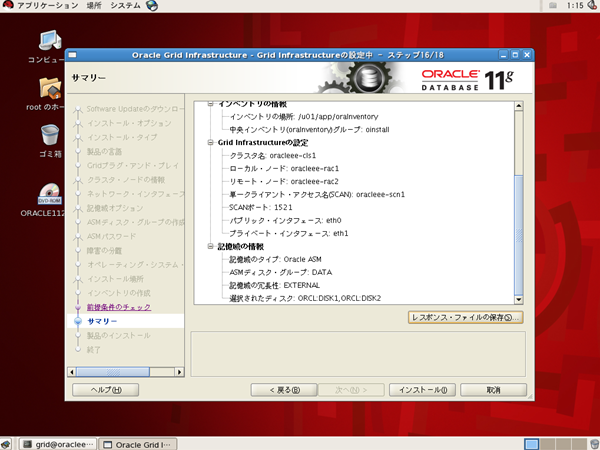

サマリー

前提条件を満たしていた場合、これまで選択してきたインストール 情報が一覧で表示されます。

スクロールして情報を確認します。

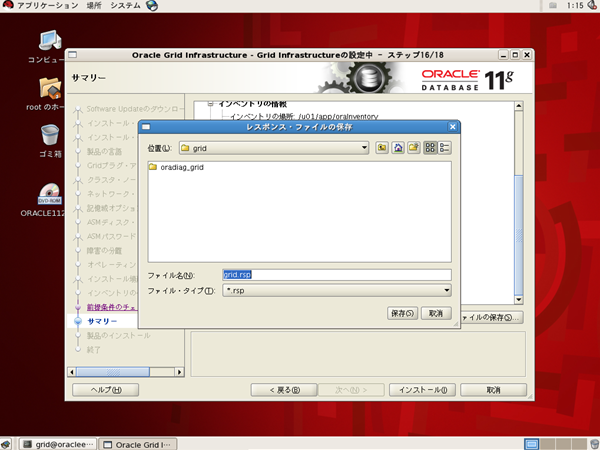

また、念のためインストール情報をレスポンス・ファイルとして保存しておきます。

レスポンス・ファイルは、Oracleをサイレントインストールする時に使用するもので、

インストールオプションのレシピが書かれたテキストファイルです。

正常にインストールが完了した場合はあまり必要ありませんが、

あとからインストールで選択したオプションを見たい場合に備えて保存しておきます。

[レスポンス・ファイルの保存]ボタンをクリックします。

保存場所は、デフォルトではgridユーザのホームディレクトリ(/home/grid)が選択されています。 特に問題ないのでここにそのまま保存します。ファイル名も変更できますが、デフォルトの grid.rsp のままとしておきます。 [保存]ボタンをクリックします。

元の「サマリー」画面に戻ったら、[インストール]ボタンをクリックします。

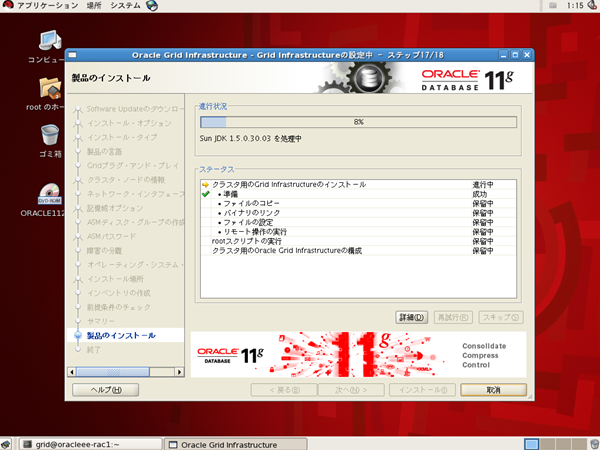

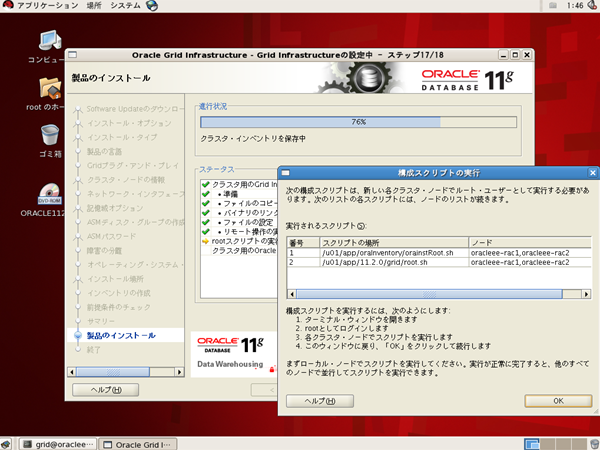

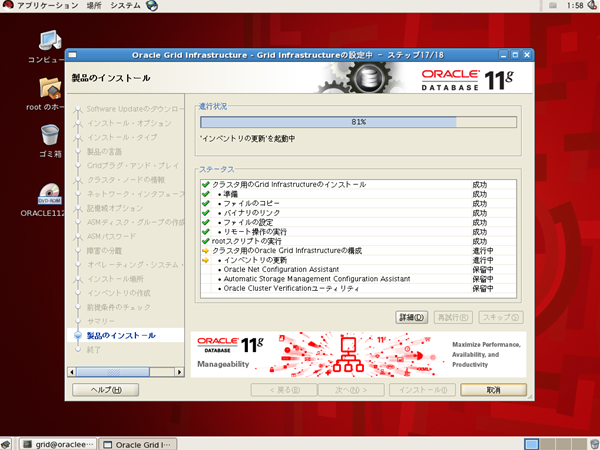

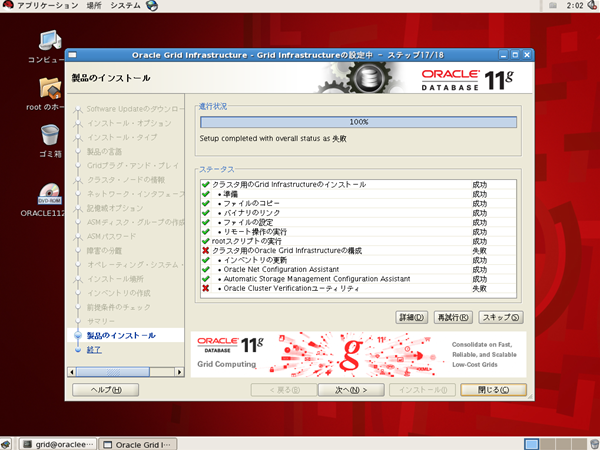

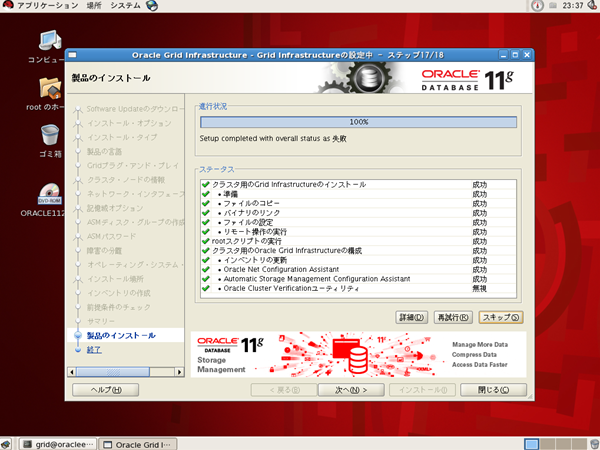

製品のインストール

指定した情報に従って、製品のインストールが開始されます。

インストールが進むと、終盤に「構成スクリプトの実行」画面が表示されます。 ターミナルを開いて、DBサーバ#1、DBサーバ#2の順で指定されたスクリプトを実行します。 スクリプトの実行にはやや時間がかかりますが、2台同時に実行してはいけません。

※DBサーバ#1で実行する※ # /u01/app/oraInventory/orainstRoot.sh 権限を変更中 /u01/app/oraInventory. グループの読取り/書込み権限を追加中。 全ユーザーの読取り/書込み/実行権限を削除中。 グループ名の変更 /u01/app/oraInventory 宛先 oinstall. スクリプトの実行が完了しました。 # /u01/app/11.2.0/grid/root.sh Performing root user operation for Oracle 11g The following environment variables are set as: ORACLE_OWNER= grid ORACLE_HOME= /u01/app/11.2.0/grid Enter the full pathname of the local bin directory: [/usr/local/bin]: ←[Enter]を押す Copying dbhome to /usr/local/bin ... Copying oraenv to /usr/local/bin ... Copying coraenv to /usr/local/bin ... Creating /etc/oratab file... Entries will be added to the /etc/oratab file as needed by Database Configuration Assistant when a database is created Finished running generic part of root script. Now product-specific root actions will be performed. Using configuration parameter file: /u01/app/11.2.0/grid/crs/install/crsconfig_params Creating trace directory OLR initialization - successful root wallet root wallet cert root cert export peer wallet profile reader wallet pa wallet peer wallet keys pa wallet keys peer cert request pa cert request peer cert pa cert peer root cert TP profile reader root cert TP pa root cert TP peer pa cert TP pa peer cert TP profile reader pa cert TP profile reader peer cert TP peer user cert pa user cert Adding Clusterware entries to inittab CRS-2672: Attempting to start 'ora.mdnsd' on 'oracleee-rac1' CRS-2676: Start of 'ora.mdnsd' on 'oracleee-rac1' succeeded CRS-2672: Attempting to start 'ora.gpnpd' on 'oracleee-rac1' CRS-2676: Start of 'ora.gpnpd' on 'oracleee-rac1' succeeded CRS-2672: Attempting to start 'ora.cssdmonitor' on 'oracleee-rac1' CRS-2672: Attempting to start 'ora.gipcd' on 'oracleee-rac1' CRS-2676: Start of 'ora.cssdmonitor' on 'oracleee-rac1' succeeded CRS-2676: Start of 'ora.gipcd' on 'oracleee-rac1' succeeded CRS-2672: Attempting to start 'ora.cssd' on 'oracleee-rac1' CRS-2672: Attempting to start 'ora.diskmon' on 'oracleee-rac1' CRS-2676: Start of 'ora.diskmon' on 'oracleee-rac1' succeeded CRS-2676: Start of 'ora.cssd' on 'oracleee-rac1' succeeded ASMは正常に作成され、起動しました。 ディスク・グループDATAは正常に作成されました。 clscfg: -install mode specified Successfully accumulated necessary OCR keys. Creating OCR keys for user 'root', privgrp 'root'.. Operation successful. CRS-4256: Updating the profile Successful addition of voting disk 95e1e87fa9074f8abf4aeab2c7085368. Successfully replaced voting disk group with +DATA. CRS-4256: Updating the profile CRS-4266: Voting file(s) successfully replaced ## STATE File Universal Id File Name Disk group -- ----- ----------------- --------- --------- 1. ONLINE 95e1e87fa9074f8abf4aeab2c7085368 (ORCL:DISK1) [DATA] Located 1 voting disk(s). CRS-2672: Attempting to start 'ora.asm' on 'oracleee-rac1' CRS-2676: Start of 'ora.asm' on 'oracleee-rac1' succeeded CRS-2672: Attempting to start 'ora.DATA.dg' on 'oracleee-rac1' CRS-2676: Start of 'ora.DATA.dg' on 'oracleee-rac1' succeeded CRS-2672: Attempting to start 'ora.registry.acfs' on 'oracleee-rac1' CRS-2676: Start of 'ora.registry.acfs' on 'oracleee-rac1' succeeded Configure Oracle Grid Infrastructure for a Cluster ... succeeded

root.sh の実行にはやや時間がかかりますが、 必ずDBサーバ#1での実行が完了してからDBサーバ#2で実行してください。

※DBサーバ#2で実行する※ # /u01/app/oraInventory/orainstRoot.sh 権限を変更中 /u01/app/oraInventory. グループの読取り/書込み権限を追加中。 全ユーザーの読取り/書込み/実行権限を削除中。 グループ名の変更 /u01/app/oraInventory 宛先 oinstall. スクリプトの実行が完了しました。 # /u01/app/11.2.0/grid/root.sh Performing root user operation for Oracle 11g The following environment variables are set as: ORACLE_OWNER= grid ORACLE_HOME= /u01/app/11.2.0/grid Enter the full pathname of the local bin directory: [/usr/local/bin]: ←[Enter]を押す Copying dbhome to /usr/local/bin ... Copying oraenv to /usr/local/bin ... Copying coraenv to /usr/local/bin ... Creating /etc/oratab file... Entries will be added to the /etc/oratab file as needed by Database Configuration Assistant when a database is created Finished running generic part of root script. Now product-specific root actions will be performed. Using configuration parameter file: /u01/app/11.2.0/grid/crs/install/crsconfig_params Creating trace directory OLR initialization - successful Adding Clusterware entries to inittab CRS-4402: CSSデーモンが排他モードで開始されましたが、ノードoracleee-rac1、番号1のアクティブCSSデーモンが検出されたため中断します An active cluster was found during exclusive startup, restarting to join the cluster Configure Oracle Grid Infrastructure for a Cluster ... succeeded

「構成スクリプトの実行」画面で[OK]ボタンをクリックすると、インストールが継続されます。

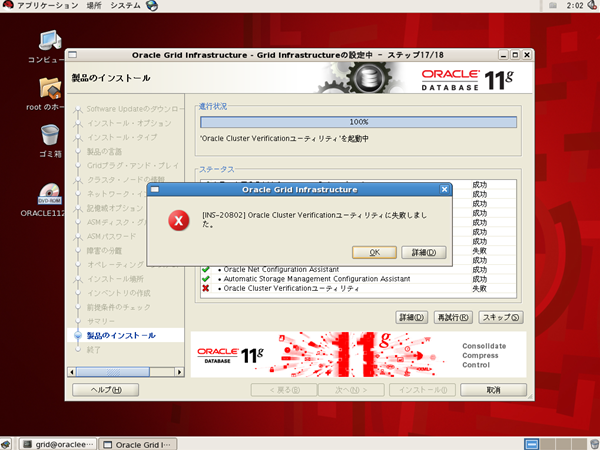

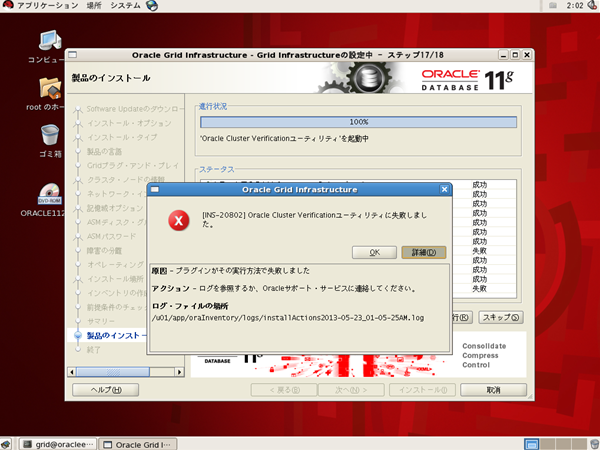

インストールの最後に以下のようなエラーメッセージが出力されることがあります。 [詳細]ボタンをクリックします。

詳細としてログファイルのパスが表示されるので、内容を確認します。 今回はSCANに関するエラーが表示されていましたが、先に進めます。 [OK]ボタンをクリックします。

「製品のインストール」画面に戻るので、[スキップ]ボタンをクリックします。

インストールに失敗した項目が[失敗]から[無視]に変わります。 [次へ]ボタンをクリックします。

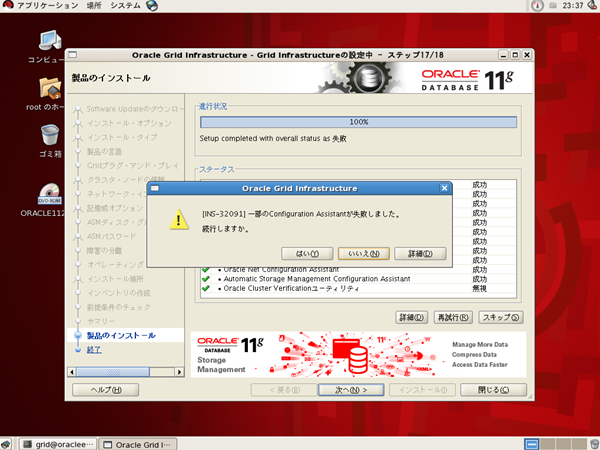

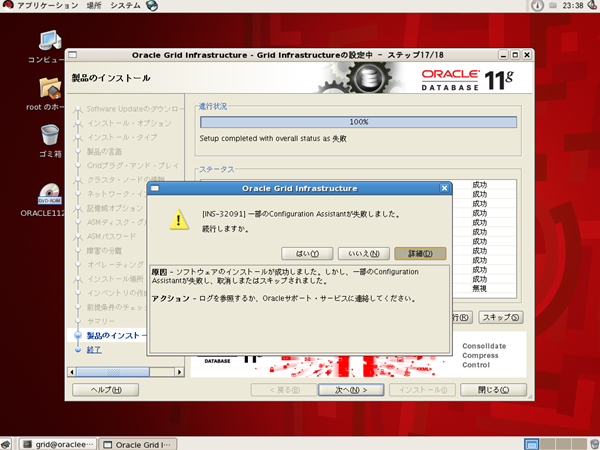

インストール中に一部の失敗をスキップして無視した場合、 最後に警告画面が表示されます。 [詳細]ボタンをクリックします。

詳細情報を確認し、[はい]ボタンをクリックします。

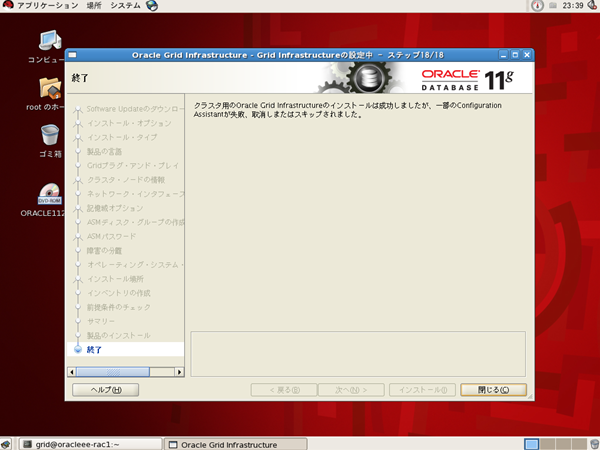

終了

以上でOracle Grid Infrastructureのインストールが終了しました。

設定

rootユーザとgridユーザの環境変数を .bash_profile に設定します。

# cd /root/ # vi .bash_profile

※ファイルの末尾に追加※

export GRID_BASE=/u01/app/grid

export GRID_HOME=/u01/app/11.2.0/grid

export PATH=$PATH:$GRID_HOME/bin

# cd /home/grid/ # vi .bash_profile

※ファイルの末尾に追加※

export GRID_BASE=/u01/app/grid

export GRID_HOME=/u01/app/11.2.0/grid

export PATH=$PATH:$GRID_HOME/bin

動作テスト

Oracle ClusterwareとOracle ASMが起動していることを確認します。 psコマンドで表示した際に、「/u01/app/11.2.0/grid/bin/プロセス名」のプロセスが Oracle Clusterwareのプロセスです。 「asm_プロセス名_インスタンス名」のプロセスが Oracle ASMのバックグラウンドプロセスです。 (一部違ったらごめんなさい)

# ps -ef | grep grid root 1659 1 0 23:24 ? 00:00:00 /u01/app/11.2.0/grid/bin/ologgerd -M -d /u01/app/11.2.0/grid/crf/db/oracleee-rac1 grid 3353 1 0 23:24 ? 00:00:00 /u01/app/11.2.0/grid/bin/oraagent.bin grid 3702 1 0 23:24 ? 00:00:00 oracle+ASM1 (DESCRIPTION=(LOCAL=YES)(ADDRESS=(PROTOCOL=beq))) root 6669 1 0 23:25 ? 00:00:03 /u01/app/11.2.0/grid/bin/orarootagent.bin grid 7312 1 0 23:25 ? 00:00:00 /u01/app/11.2.0/grid/opmn/bin/ons -d grid 7313 7312 0 23:25 ? 00:00:00 /u01/app/11.2.0/grid/opmn/bin/ons -d grid 8203 1 0 23:25 ? 00:00:00 /u01/app/11.2.0/grid/bin/tnslsnr LISTENER_SCAN1 -inherit grid 8921 1 0 23:25 ? 00:00:00 /u01/app/11.2.0/grid/bin/scriptagent.bin grid 9083 1 0 23:25 ? 00:00:07 /u01/app/11.2.0/grid/jdk/jre//bin/java -server -Xcheck:jni -Xms128M -Xmx384M -Djava.awt.headless=true -Ddisable.checkForUpdate=true -Dstdstream.filesize=100 -Dstdstream.filenumber=10 -DTRACING.ENABLED=false -Doracle.wlm.dbwlmlogger.logging.level=INFO -Dport.rmi=23792 -jar /u01/app/11.2.0/grid/oc4j/j2ee/home/oc4j.jar -config /u01/app/11.2.0/grid/oc4j/j2ee/home/OC4J_DBWLM_config/server.xml -out /u01/app/11.2.0/grid/oc4j/j2ee/home/log/oc4j.out -err /u01/app/11.2.0/grid/oc4j/j2ee/home/log/oc4j.err root 15456 1 0 23:19 ? 00:00:03 /u01/app/11.2.0/grid/bin/ohasd.bin reboot root 17574 1 0 23:21 ? 00:00:04 /u01/app/11.2.0/grid/bin/orarootagent.bin grid 18382 1 0 23:32 ? 00:00:00 /u01/app/11.2.0/grid/bin/tnslsnr LISTENER -inherit grid 19054 1 0 23:22 ? 00:00:01 /u01/app/11.2.0/grid/bin/oraagent.bin grid 19068 1 0 23:22 ? 00:00:00 /u01/app/11.2.0/grid/bin/mdnsd.bin grid 19085 1 0 23:22 ? 00:00:00 /u01/app/11.2.0/grid/bin/gpnpd.bin root 19108 1 0 23:22 ? 00:00:00 /u01/app/11.2.0/grid/bin/cssdmonitor grid 19111 1 0 23:22 ? 00:00:01 /u01/app/11.2.0/grid/bin/gipcd.bin root 19135 1 0 23:22 ? 00:00:00 /u01/app/11.2.0/grid/bin/cssdagent grid 19149 1 0 23:22 ? 00:00:03 /u01/app/11.2.0/grid/bin/ocssd.bin root 19231 1 0 23:23 ? 00:00:00 /u01/app/11.2.0/grid/bin/octssd.bin root 19261 1 0 23:23 ? 00:00:02 /u01/app/11.2.0/grid/bin/osysmond.bin root 21283 5043 0 23:41 pts/1 00:00:00 grep grid grid 21492 1 0 23:23 ? 00:00:00 asm_pmon_+ASM1 grid 21498 1 0 23:23 ? 00:00:00 asm_psp0_+ASM1 grid 21504 1 0 23:23 ? 00:00:00 asm_vktm_+ASM1 grid 21512 1 0 23:23 ? 00:00:00 asm_gen0_+ASM1 grid 21518 1 0 23:23 ? 00:00:00 asm_diag_+ASM1 grid 21523 1 0 23:23 ? 00:00:00 asm_ping_+ASM1 grid 21532 1 0 23:23 ? 00:00:00 asm_dia0_+ASM1 grid 21538 1 0 23:23 ? 00:00:00 asm_lmon_+ASM1 grid 21543 1 0 23:23 ? 00:00:00 asm_lmd0_+ASM1 grid 21548 1 0 23:23 ? 00:00:00 asm_lms0_+ASM1 grid 21556 1 0 23:23 ? 00:00:00 asm_lmhb_+ASM1 grid 21560 1 0 23:23 ? 00:00:00 asm_mman_+ASM1 grid 21564 1 0 23:23 ? 00:00:00 asm_dbw0_+ASM1 grid 21572 1 0 23:23 ? 00:00:00 asm_lgwr_+ASM1 grid 21578 1 0 23:23 ? 00:00:00 asm_ckpt_+ASM1 grid 21586 1 0 23:23 ? 00:00:00 asm_smon_+ASM1 grid 21592 1 0 23:23 ? 00:00:00 asm_rbal_+ASM1 grid 21599 1 0 23:23 ? 00:00:00 asm_gmon_+ASM1 grid 21606 1 0 23:23 ? 00:00:00 asm_mmon_+ASM1 grid 21614 1 0 23:23 ? 00:00:00 asm_mmnl_+ASM1 grid 21754 1 0 23:23 ? 00:00:00 asm_lck0_+ASM1 grid 21915 1 0 23:23 ? 00:00:00 oracle+ASM1 (DESCRIPTION=(LOCAL=YES)(ADDRESS=(PROTOCOL=beq))) root 23081 1 0 23:23 ? 00:00:02 /u01/app/11.2.0/grid/bin/crsd.bin reboot grid 23448 1 0 23:24 ? 00:00:00 /u01/app/11.2.0/grid/bin/evmd.bin grid 23459 1 0 23:24 ? 00:00:00 oracle+ASM1_ocr (DESCRIPTION=(LOCAL=YES)(ADDRESS=(PROTOCOL=beq))) grid 23465 1 0 23:24 ? 00:00:00 asm_asmb_+ASM1 grid 23469 1 0 23:24 ? 00:00:00 oracle+ASM1_asmb_+asm1 (DESCRIPTION=(LOCAL=YES)(ADDRESS=(PROTOCOL=beq))) grid 24100 23448 0 23:24 ? 00:00:00 /u01/app/11.2.0/grid/bin/evmlogger.bin -o /u01/app/11.2.0/grid/evm/log/evmlogger.info -l /u01/app/11.2.0/grid/evm/log/evmlogger.log